W dzisiejszym cyfrowym świecie dostęp do informacji jest na wyciągnięcie ręki. Często jednak pojawia się potrzeba, aby tę zawartość zachować na później, przeglądać offline lub przetwarzać w inny sposób. W tym artykule, jako doświadczony praktyk, przeprowadzę Cię przez różnorodne metody pobierania treści ze stron internetowych od najprostszych, dostępnych w każdej przeglądarce, po zaawansowane techniki web scrapingu, które pozwalają na automatyzację tego procesu.

Pobieranie zawartości strony internetowej: Poznaj skuteczne metody i narzędzia dla każdego

- Najprostsze metody to "Zapisz jako" (Ctrl+S) lub "Drukuj do PDF", idealne do szybkiego zapisu treści offline.

- Do pobierania całych witryn służą dedykowane programy, takie jak HTTrack Website Copier, tworzące lustrzane kopie.

- Wtyczki do przeglądarek oferują wygodne rozwiązania do zapisywania stron lub ich elementów w jednym pliku.

- Dla dynamicznych stron, opartych na JavaScript, tradycyjne metody mogą być niewystarczające tu przydaje się web scraping.

- Web scraping, wykorzystujący narzędzia programistyczne (np. Python z BeautifulSoup), pozwala na automatyczne pobieranie konkretnych danych.

- Zawsze pamiętaj o aspektach prawnych: dozwolony użytek osobisty, regulaminy stron i przepisy RODO są kluczowe.

Zacznijmy od podstaw: Jak najprościej zapisać stronę na swoim komputerze?

Zanim zagłębimy się w bardziej skomplikowane techniki, warto przypomnieć sobie o najprostszych i najszybszych sposobach na zapisanie zawartości strony internetowej. Te metody są dostępne bezpośrednio w Twojej przeglądarce i idealnie nadają się do codziennego użytku, gdy potrzebujesz szybko zachować artykuł, przepis czy ważną informację.

Zapisz stronę do czytania offline jednym skrótem klawiszowym (Ctrl+S)

To chyba najbardziej podstawowa, a zarazem niezwykle przydatna funkcja. Wystarczy, że będąc na interesującej Cię stronie, naciśniesz Ctrl+S (lub Cmd+S na Macu). Przeglądarka wyświetli okno dialogowe zapisu. Zazwyczaj domyślną opcją jest "Strona internetowa, kompletna" (lub podobna nazwa, np. "Webpage, complete"). Wybierz tę opcję, a przeglądarka zapisze plik HTML strony oraz utworzy folder z wszystkimi zasobami obrazami, plikami CSS i JavaScript. Dzięki temu strona będzie wyglądać i działać niemal identycznie jak online, ale będziesz mógł ją przeglądać bez dostępu do internetu. To świetne rozwiązanie do archiwizacji artykułów, dokumentacji czy stron, które mogą zniknąć z sieci.

Kiedy opcja "Drukuj do PDF" to najlepsze rozwiązanie?

Opcja "Drukuj do PDF" to kolejna wbudowana funkcja, która jest niezwykle użyteczna. Zamiast drukować stronę na papierze, możesz wybrać opcję "Zapisz jako PDF" (lub podobną, w zależności od przeglądarki i systemu operacyjnego). Spowoduje to utworzenie statycznej, wizualnej kopii strony w formacie PDF. Jest to idealne rozwiązanie, gdy zależy Ci na zachowaniu dokładnego wyglądu strony w momencie zapisu, bez obawy o zmiany w kodzie czy brakujące zasoby. Pliki PDF są łatwe do udostępniania, archiwizacji i przeglądania na różnych urządzeniach, a ich układ zazwyczaj jest bardziej przewidywalny niż w przypadku plików HTML zapisanych lokalnie.

Zapisywanie pojedynczych elementów: jak pobrać tylko tekst lub obrazy?

- Tekst: Najprostszym sposobem na pobranie samego tekstu jest klasyczne kopiuj-wklej. Zaznacz interesujący Cię fragment, skopiuj go (Ctrl+C / Cmd+C) i wklej do dowolnego edytora tekstu (Ctrl+V / Cmd+V).

- Obrazy: Aby zapisać pojedynczy obraz, wystarczy kliknąć na niego prawym przyciskiem myszy i wybrać opcję "Zapisz obraz jako..." (lub "Save image as..."). Możesz wtedy wybrać lokalizację i nazwę pliku. To szybka i skuteczna metoda na gromadzenie grafik.

Chcesz pobrać całą witrynę? Oto narzędzia, które zrobią to za Ciebie

Czasami samo zapisanie pojedynczej strony to za mało. Jeśli chcesz mieć dostęp do całej witryny, z jej wewnętrznymi linkami i strukturą, potrzebujesz bardziej zaawansowanych narzędzi. Na szczęście istnieją programy, które specjalizują się w tworzeniu "lustrzanych kopii" stron internetowych, umożliwiając przeglądanie ich offline.

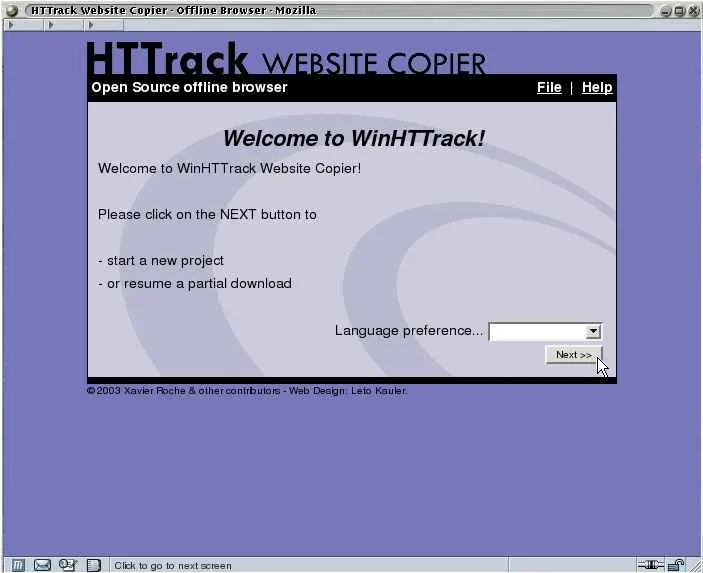

HTTrack Website Copier: Twój osobisty archiwizator stron WWW krok po kroku

HTTrack Website Copier to jedno z najbardziej znanych i cenionych darmowych narzędzi do pobierania całych witryn internetowych. Działa na zasadzie tworzenia lustrzanej kopii strony na Twoim lokalnym dysku. Oznacza to, że program analizuje strukturę witryny, podąża za linkami i pobiera wszystkie powiązane pliki (HTML, CSS, JavaScript, obrazy, wideo itp.), zachowując ich oryginalną hierarchię. Po zakończeniu procesu możesz przeglądać taką stronę offline, klikając w linki tak, jakbyś był online. Jest to idealne rozwiązanie do archiwizacji całych serwisów, tworzenia kopii zapasowych własnych stron lub do nauki, jak zbudowane są inne witryny.

Cyotek WebCopy: Potężna alternatywa dla wymagających użytkowników

Cyotek WebCopy to kolejna godna uwagi aplikacja do pobierania stron internetowych, oferująca nieco bardziej rozbudowane opcje konfiguracji niż HTTrack. Pozwala na precyzyjne określenie, które elementy strony mają być pobierane, a które ignorowane, a także oferuje zaawansowane opcje filtrowania i zarządzania linkami. Jeśli potrzebujesz większej kontroli nad procesem pobierania, na przykład chcesz wykluczyć konkretne typy plików lub ścieżki, Cyotek WebCopy może okazać się potężnym narzędziem w Twoim arsenale.

Przegląd popularnych wtyczek do przeglądarki, które ułatwiają życie

- Save Page WE: Ta wtyczka do przeglądarek (dostępna m.in. dla Firefoxa) pozwala na zapisanie całej strony internetowej jako pojedynczego pliku HTML, który zawiera wszystkie zasoby (obrazy, CSS) osadzone bezpośrednio w kodzie. To bardzo wygodne, gdy chcesz mieć wszystko w jednym miejscu i uniknąć tworzenia dodatkowych folderów.

- SingleFile: Podobnie jak Save Page WE, SingleFile umożliwia zapisanie kompletnej strony internetowej (wraz z CSS, obrazami, fontami itp.) w jednym pliku HTML. Jest to niezwykle przydatne do archiwizacji i udostępniania stron, ponieważ nie musisz martwić się o brakujące zasoby.

- GoFullPage: Chociaż nie pobiera kodu strony, GoFullPage jest doskonałym narzędziem do tworzenia zrzutów ekranu całej strony internetowej, nawet tych bardzo długich. Zapisuje je jako plik graficzny (PNG lub JPG), co jest świetnym sposobem na wizualną archiwizację wyglądu strony w danym momencie.

Co zrobić, gdy proste metody zawodzą? Witaj w świecie dynamicznych stron

Współczesne strony internetowe są coraz bardziej interaktywne i dynamiczne. Niestety, to, co jest zaletą dla użytkownika, często staje się wyzwaniem, gdy próbujemy pobrać ich zawartość za pomocą tradycyjnych metod. Jeśli kiedykolwiek próbowałeś zapisać stronę i zauważyłeś, że brakuje na niej kluczowych elementów, prawdopodobnie natknąłeś się na dynamiczną zawartość.

Dlaczego nie mogę pobrać treści z nowoczesnych stron? Rola JavaScript

Wiele nowoczesnych stron internetowych, zbudowanych przy użyciu frameworków takich jak React, Angular czy Vue.js, ładowanie treści opiera na JavaScript. Oznacza to, że początkowy kod HTML, który przeglądarka otrzymuje od serwera, jest często bardzo skromny. Dopiero po uruchomieniu skryptów JavaScript w przeglądarce, treść jest dynamicznie generowana i wstrzykiwana do strony. Tradycyjne metody zapisu (Ctrl+S, HTTrack) zazwyczaj pobierają tylko ten początkowy, "pusty" HTML, ignorując proces renderowania JavaScript. Dlatego właśnie widzisz niekompletną stronę brakuje jej treści, która miała zostać wygenerowana przez skrypty.

Jak narzędzia deweloperskie w przeglądarce (F12) mogą Ci pomóc?

Narzędzia deweloperskie, dostępne po naciśnięciu klawisza F12 w większości przeglądarek, to potężne centrum dowodzenia dla każdego, kto chce zrozumieć, jak działa strona internetowa. Choć nie służą bezpośrednio do pobierania treści, są nieocenione w analizie dynamicznych stron. Możesz:

- Inspekcjonować elementy (Elements tab): Zobaczysz faktyczny kod HTML strony po tym, jak JavaScript wygenerował całą zawartość. Możesz stamtąd kopiować konkretne fragmenty kodu.

- Monitorować żądania sieciowe (Network tab): Zobaczysz, jakie dane strona pobiera z serwera po załadowaniu. Czasami kluczowe dane są przesyłane w formacie JSON lub XML, które można przechwycić i przetworzyć.

Czym jest web scraping i kiedy warto się nim zainteresować?

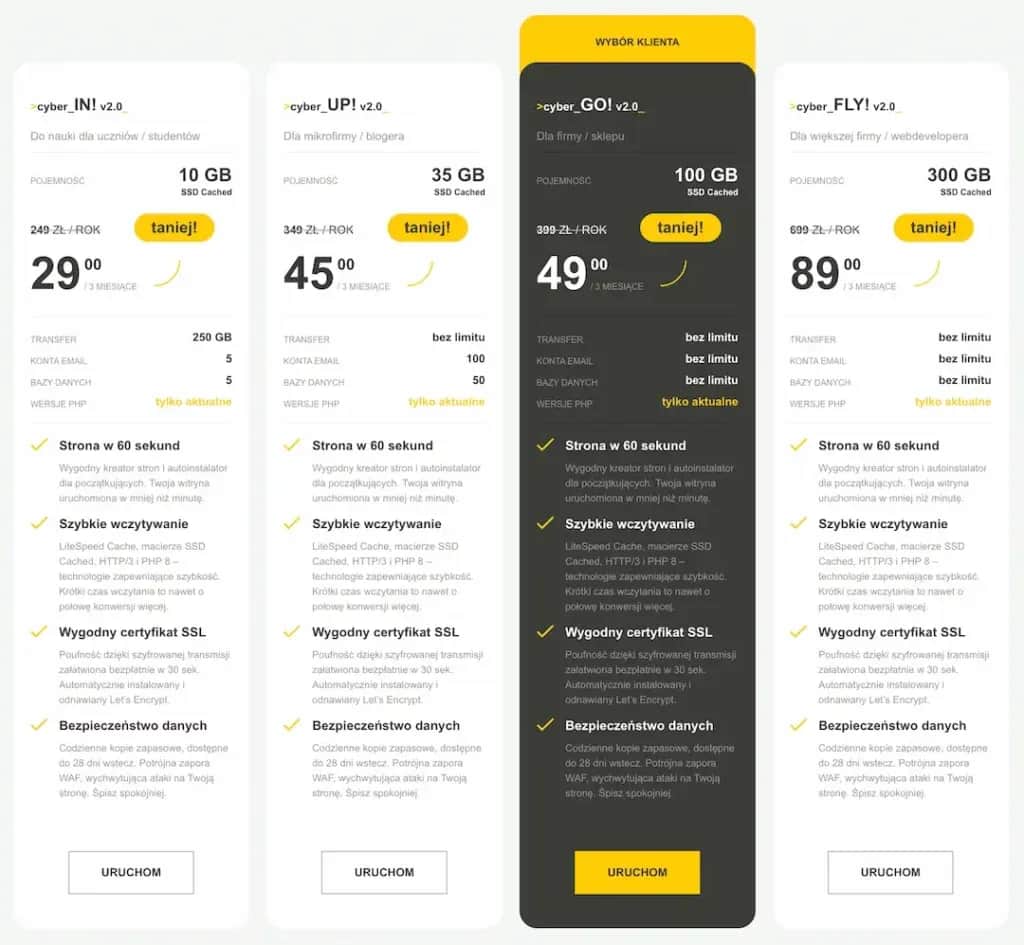

Web scraping to technika automatycznego pobierania danych ze stron internetowych. Zamiast ręcznie kopiować i wklejać informacje, tworzysz program (scraper), który "czyta" stronę internetową, identyfikuje interesujące Cię elementy i wyodrębnia z nich dane w ustrukturyzowany sposób (np. do pliku CSV, bazy danych). Warto się nim zainteresować, gdy:- Potrzebujesz masowo pobierać konkretne, strukturalne dane (np. ceny produktów, dane kontaktowe, nagłówki artykułów, recenzje).

- Dane są rozproszone na wielu stronach, a ręczne zbieranie byłoby zbyt czasochłonne.

- Strona jest dynamiczna i tradycyjne metody zawiodły.

Web scraping dla początkujących: Wprowadzenie do automatycznego pobierania danych

Web scraping, choć brzmi technicznie, jest dostępny dla każdego, kto ma podstawową wiedzę o komputerach i chęć nauki. Na początku może wydawać się skomplikowany, ale z odpowiednimi narzędziami i podejściem, możesz zacząć automatycznie zbierać dane, które są dla Ciebie ważne.

Najpopularniejsze narzędzia do scrapingu, które nie wymagają programowania

Dla osób, które nie chcą zagłębiać się w kodowanie, istnieją narzędzia typu "no-code" lub "low-code" do web scrapingu. Pozwalają one na wizualne wskazanie elementów na stronie, które mają zostać pobrane, a następnie automatyzują proces. Przykładami takich narzędzi są Octoparse, ParseHub czy Web Scraper (wtyczka do Chrome). Są one świetnym punktem wyjścia, aby zrozumieć podstawy scrapingu i szybko uzyskać pierwsze rezultaty.

Python w akcji: Biblioteki BeautifulSoup i Scrapy jako standard w branży

Jeśli myślisz o poważniejszym web scrapingu, Python jest bez wątpienia językiem, w którym powinieneś się specjalizować. Oferuje on potężne biblioteki, które ułatwiają ten proces:

- BeautifulSoup: To biblioteka do parsowania dokumentów HTML i XML. Pozwala na łatwe nawigowanie po strukturze strony, wyszukiwanie elementów po tagach, klasach czy identyfikatorach i wyodrębnianie z nich danych. Jest stosunkowo prosta w użyciu i idealna do mniejszych projektów.

- Scrapy: Jest to kompletny framework do web scrapingu. Scrapy to znacznie więcej niż tylko parser to całe środowisko do budowania skalowalnych i wydajnych scraperów. Radzi sobie z kolejkami żądań, obsługą ciasteczek, limitowaniem prędkości i wieloma innymi aspektami, które są kluczowe przy dużych projektach.

- Selenium: Gdy strona jest bardzo dynamiczna i wymaga interakcji (kliknięcia, przewijania, logowania), BeautifulSoup i Scrapy mogą być niewystarczające. Wtedy do gry wkracza Selenium. Jest to narzędzie do automatyzacji przeglądarek, które pozwala na sterowanie przeglądarką (np. Chrome) tak, jak robiłby to człowiek. Dzięki temu możesz "zobaczyć" i pobrać treści generowane przez JavaScript.

Jak radzić sobie z najczęstszymi przeszkodami: logowanie i CAPTCHA

Web scraping nie zawsze jest prosty. Właściciele stron często stosują mechanizmy obronne, aby utrudnić automatyczne pobieranie danych. Do najczęstszych przeszkód należą:

- Blokady IP: Strony mogą blokować adresy IP, z których pochodzi zbyt wiele żądań. Rozwiązaniem są serwery proxy lub rotacja adresów IP.

- Pliki robots.txt: To plik, który informuje roboty (w tym scrapery), które części strony są przeznaczone do indeksowania, a które nie. Zawsze warto go sprawdzić.

- Wymogi logowania: Niektóre dane są dostępne tylko po zalogowaniu. W takich przypadkach scraper musi symulować proces logowania, co jest możliwe np. za pomocą Selenium.

- CAPTCHA: To testy mające na celu odróżnienie człowieka od bota. Radzenie sobie z CAPTCHA jest jednym z największych wyzwań i często wymaga integracji z zewnętrznymi serwisami do rozwiązywania CAPTCHA lub użycia bardziej zaawansowanych technik (np. uczenia maszynowego).

Czy pobieranie treści ze stron jest legalne? Kluczowe aspekty prawne w Polsce

Zanim zaczniesz masowo pobierać dane, musisz zrozumieć, że nie wszystko, co technicznie możliwe, jest prawnie dozwolone. W Polsce, podobnie jak w innych krajach, istnieją regulacje dotyczące praw autorskich, ochrony danych osobowych i ogólnych zasad korzystania z internetu. Ignorowanie ich może prowadzić do poważnych konsekwencji.

Dozwolony użytek osobisty: Co wolno, a czego nie wolno robić z pobraną treścią?

Polskie prawo autorskie (Ustawa o prawie autorskim i prawach pokrewnych) przewiduje koncepcję dozwolonego użytku osobistego. Oznacza to, że możesz pobierać i kopiować utwory (w tym treści ze stron internetowych) na własny użytek, dla kręgu osób pozostających w związku osobistym, w szczególności pokrewieństwa, powinowactwa lub stosunku towarzyskiego. Ważne jest jednak, aby nie łamać przy tym zabezpieczeń technicznych strony. Jeśli strona aktywnie uniemożliwia pobieranie treści (np. przez blokady), omijanie tych zabezpieczeń może być już naruszeniem. Kluczowe jest, że dozwolony użytek osobisty dotyczy tylko użytku niekomercyjnego i prywatnego. Jakiekolwiek dalsze rozpowszechnianie, modyfikowanie czy komercyjne wykorzystanie pobranych treści bez zgody autora jest zazwyczaj nielegalne.

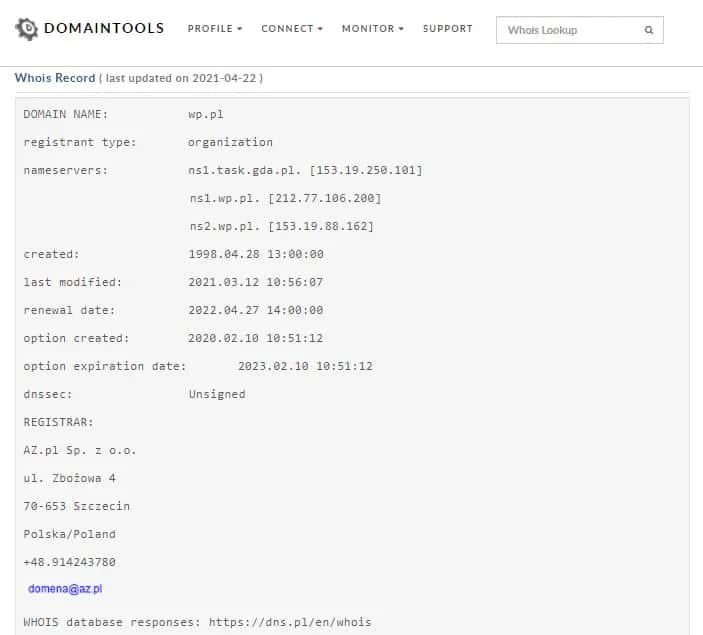

Regulamin strony jako Twoja pierwsza "instrukcja obsługi"

Zawsze, zanim zaczniesz pobierać treści ze strony, zapoznaj się z jej regulaminem. Wiele serwisów internetowych, zwłaszcza tych komercyjnych (np. sklepy, portale ogłoszeniowe), zawiera w swoich regulaminach wyraźne zapisy dotyczące automatycznego pobierania treści (scrapingu). Bardzo często takie działania są wprost zakazane. Naruszenie regulaminu może skutkować zablokowaniem dostępu do serwisu, a w skrajnych przypadkach pozwem sądowym. Regulamin to umowa między Tobą a właścicielem strony, a jego złamanie niesie za sobą konsekwencje.

Kiedy pobieranie danych staje się naruszeniem RODO?

Rozporządzenie o Ochronie Danych Osobowych (RODO) jest kluczowe, gdy w grę wchodzi pobieranie danych osobowych. Jeśli Twój scraping obejmuje zbieranie informacji, które pozwalają na identyfikację osoby fizycznej (np. imiona i nazwiska, adresy e-mail, numery telefonów, zdjęcia), musisz być niezwykle ostrożny. Pobieranie danych osobowych bez odpowiedniej podstawy prawnej i zgody osób, których dane dotyczą, jest naruszeniem RODO. Nawet jeśli dane są publicznie dostępne na stronie, ich masowe zbieranie i przetwarzanie wymaga przestrzegania zasad RODO. Zawsze zadaj sobie pytanie: czy mam prawo do przetwarzania tych danych? Czy informuję o tym osoby, których dane dotyczą?

Plik robots.txt: Jak sprawdzić, na co pozwala właściciel witryny?

Plik robots.txt to prosty plik tekstowy umieszczony w katalogu głównym witryny (np. www.przyklad.pl/robots.txt), który służy do komunikowania się z robotami internetowymi (takimi jak wyszukiwarki czy właśnie scrapery). Właściciele witryn mogą za jego pomocą wskazać, które części strony są przeznaczone do indeksowania, a które powinny być ignorowane. Na przykład, zapis Disallow: /admin/ oznacza, że roboty nie powinny wchodzić do katalogu /admin/. Chociaż plik robots.txt nie jest prawnie wiążący (jest to raczej prośba niż nakaz), etyczne i profesjonalne podejście do scrapingu wymaga jego poszanowania. Ignorowanie go może być również sygnałem dla właściciela strony, że Twoje działania są niepożądane, co może skutkować blokadami.

Podsumowanie: Wybierz metodę idealnie dopasowaną do Twoich potrzeb

Jak widzisz, istnieje wiele sposobów na pobieranie treści ze stron internetowych, a wybór odpowiedniej metody zależy od Twoich konkretnych potrzeb i poziomu zaawansowania. Od prostych funkcji przeglądarki po zaawansowane skrypty każda technika ma swoje zastosowania i ograniczenia. Mam nadzieję, że ten przewodnik pomógł Ci zrozumieć dostępne opcje i podjąć świadomą decyzję.

Kiedy wystarczy Ci proste zapisanie strony, a kiedy potrzebujesz zaawansowanych narzędzi?

Jeśli potrzebujesz szybko zachować pojedynczy artykuł, przepis lub wizualną kopię strony do przeglądania offline, proste metody takie jak Ctrl+S lub "Drukuj do PDF" są w zupełności wystarczające. Są łatwe w użyciu i nie wymagają żadnej wiedzy technicznej. Gdy jednak Twoje potrzeby rosną chcesz pobrać całą witrynę, monitorować zmiany, zbierać duże ilości strukturalnych danych, a zwłaszcza gdy masz do czynienia z dynamicznymi stronami wtedy konieczne staje się sięgnięcie po zaawansowane narzędzia do web scrapingu, takie jak HTTrack, wtyczki przeglądarkowe, a w końcu Python z bibliotekami takimi jak BeautifulSoup, Scrapy czy Selenium. Pamiętaj, że im bardziej złożone zadanie, tym większa wiedza i narzędzia będą Ci potrzebne.

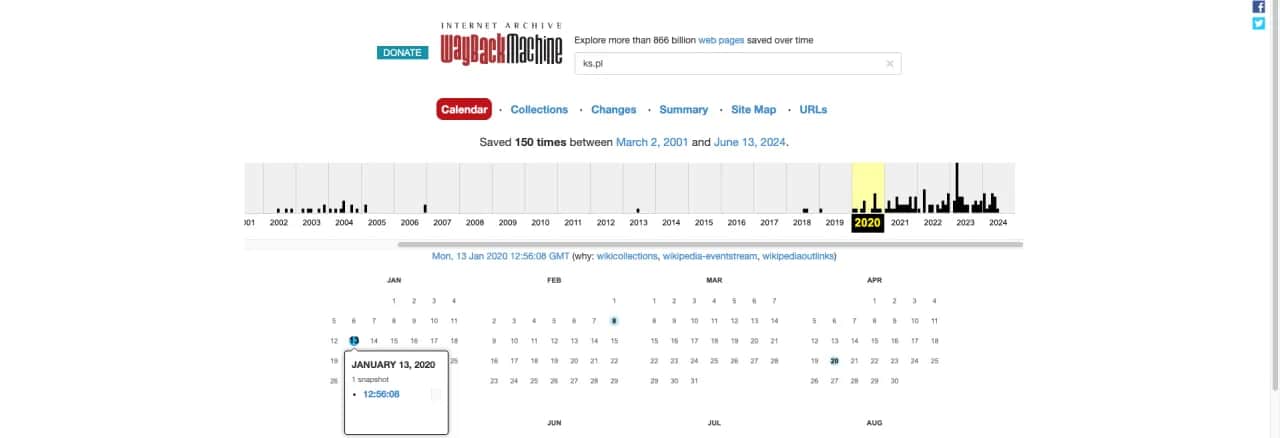

Przeczytaj również: Odkryj przeszłość: Jak sprawdzić historię strony internetowej?

Kluczowe zasady etycznego pobierania treści z internetu

- Szanuj regulaminy stron: Zawsze sprawdzaj regulamin serwisu. Jeśli scraping jest zabroniony, szanuj tę decyzję.

- Nie przeciążaj serwerów: Ustawiaj odpowiednie opóźnienia między żądaniami (np. 5-10 sekund), aby nie obciążać serwerów witryny. Masowe, szybkie żądania mogą być interpretowane jako atak DDoS.

- Poszanuj plik robots.txt: Traktuj go jako wskazówkę od właściciela strony, które obszary są przeznaczone dla robotów, a które nie.

- Bądź świadomy konsekwencji prawnych: Zawsze pamiętaj o prawie autorskim i RODO, zwłaszcza gdy pobierasz dane osobowe lub planujesz komercyjne wykorzystanie treści.

- Nie omijaj zabezpieczeń w sposób nieetyczny lub nielegalny: Nie łam zabezpieczeń strony ani nie wykorzystuj luk bezpieczeństwa.